Bazı sayfaların arama motorları ve diğer botlar tarafından taranmasını isterken, bazı sayfaların ise gizli kalmasını tercih edebilirsiniz. Bu isteği yerine getirebilmek için en yaygın kullanılan yöntem robots.txt dosyasını kullanmaktır. Robots.txt dosyası, botların hangi sayfaları tarayıp hangi sayfalardan kaçınması gerektiğini belirleyen basit ama etkili bir araçtır. İçeriğimizin devamında, bu dosyanın ne olduğunu, nasıl kullanıldığını ve önemli komutları ayrıntılı bir şekilde açıklayacağız.

Robots.txt Dosyası Nedir?

Robots.txt dosyası, arama motorlarına ait botların bir web sitesine girdiğinde hangi sayfalara erişebileceğini ve hangilerine erişemeyeceğini belirten bir metin dosyasıdır.

Bu dosya, botların gereksiz sayfalarda zaman kaybetmesini engelleyerek, arama motorlarının siteyi daha hızlı ve verimli bir şekilde taramasına yardımcı olur.Arama motoru botlarının, web siteleri için ayırdıkları tarama kaynaklarının bir sınırı bulunmaktadır. Bu sınırı gereksiz sayfalarla aşmamak ve kaynakları daha verimli kullanmak adına, yönlendirmeler yapmak ve önemsiz kısımlara erişimi engellemek, avantajlı sonuçlar elde edilmesini sağlar.

Robots.txt Dosyası Neden Önemlidir ?

Web sitelerine arama motoru botları girdiğinde, ilk olarak robots.txt dosyasını inceler ve bu dosyadaki komutlara uygun şekilde hareket etmeye başlar. Bu nedenle, site sahiplerinin doğru stratejiler kullanarak robots.txt dosyasını hazırlamaları ve her bir komutun sorunsuz çalıştığından emin olmaları önemlidir. Eğer komutların doğru çalıştığına emin olunmazsa, yanlış yapılandırılmış komutlar, siteyi üst sıralara taşıyabilecek sayfaların gözden çıkarılmasına yol açabilir ve bu durum siteye faydadan çok zarar verebilir.

Robots.txt dosyasının en fazla fayda sağladığı alan, SEO çalışmalarında karşımıza çıkar. Arama motoru botları, her bir web sitesi için belirli bir miktar kaynak ayırır ve bu kaynak tükenene kadar tarama işlemini gerçekleştirir. Doğru komutlar kullanarak gereksiz sayfaların taranmasını engelleyen bir site sahibi, SEO çalışmalarından daha yüksek verim elde edebilir.

Robots.txt Dosyası Nasıl Oluşturulur?

Çok basit bir metin belgesi olan robots.txt dosyasını oluşturmak için TextEdit, Notepad gibi herhangi bir metin belgesi düzenleyicisi kullanabilirsiniz. Kısacası, uzantısı .txt olan dosya formatında oluşturulabilen her türlü uygulama tercih edilebilir.

Temiz bir .txt dosyası açıp, ismini robots.txt koyduktan sonra, dilediğiniz komutları bu dosyanın içerisine yazabilirsiniz.

Dosyayı oluşturduktan sonra, robots.txt dosyasının sitenin ana dizinine yerleştirilmesi gerekmektedir. Örnek olarak, web sitesi adı ‘https://tulidijital.com/’ olan bir sitede robots.txt dosyası ‘https://tulidijital.com.com/robots.txt’ şeklinde yerleştirilmiş olmalıdır. Eğer alt dizine (örneğin: ‘https://tulidijital.com/sayfax/robots.txt’) yerleştirilirse, dosya çalışmayacaktır.

Sitenin kök dizinine erişim konusunda sorun yaşayan site sahipleri, bu konuda hosting sağlayıcılarından yardım alabilir.

Robots.txt Oluşturmak İçin Kullanabileceğiniz Araçlar

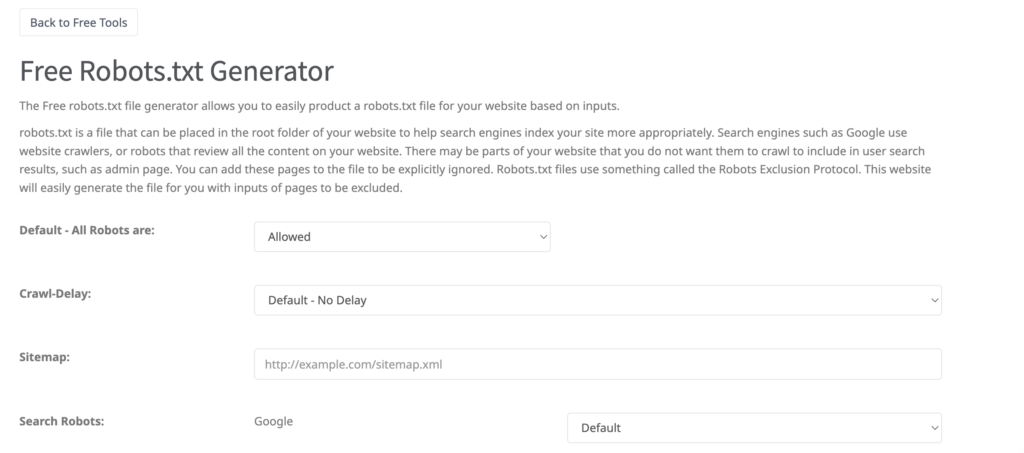

Eğer Notepad veya TextEdit gibi basit metin düzenleyicileri kullanarak robots.txt dosyası oluşturmak istemiyorsanız, bunun yerine daha kullanıcı dostu ve pratik araçlardan yararlanabilirsiniz. Bu araçlar, komutları doğru şekilde yazmanıza ve dosyanın hatasız çalışmasını sağlamanıza yardımcı olur.

SEOptimer Robots.txt Generator: Kullanıcı dostu bir arayüze sahip bu araç, size adım adım rehberlik ederek doğru komutları hızlıca oluşturmanızı sağlar.

SEO HOCASI Robots.txt Generator: Bu araç da aynı şekilde, SEO ihtiyaçlarınıza uygun robots.txt dosyalarını kolayca oluşturmanıza yardımcı olur.

Bu araçlar sayesinde, karmaşık komutları yazmakla uğraşmadan, doğru yapılandırılmış bir robots.txt dosyasına sahip olabilirsiniz.

Önemli Bazı Robots.txt Komutları

Temel ve önemli bazı robots.txt komutları vardır. Bu komutları birden fazla kez kullanarak, arama motoru botlarının sitede nasıl gezinti yapacağını belirleyen SEO stratejileri oluşturabilirsiniz.

User-agent

User-agent komutuyla hangi arama motoruna ait botlara komut verdiğinizi belirleyebilir veya tüm botların tarama yapmasına izin verebilirsiniz. Bu komutu birden fazla kez kullanarak, farklı botlar için farklı komutlar oluşturabilirsiniz

User-agent: *

Disallow: /private/

Yukarıdaki örnekte, tüm botlar için /private/ dizinine erişim engellenmiştir.

Allow Komutu

Allow komutu, arama motoru botlarına belirli bir sayfa veya dizine erişim izni vermek için kullanılır.

User-agent: *

Allow: /demo/x-content

Bu komut, tüm botların /demo/x-content içeriğine erişimine izin verir.

Disallow Komutu

Bu komutu vererek arama motoru botlarının girmesini istemediğiniz sayfa veya sayfa grubunu belirtebilirsiniz.

User-agent: *

Disallow: /demo/

Bu komut, tüm botların /demo/ içeriğine erişimini engeller.

Sitemap Komutu

Bu komutu verdiğinizde, arama motorlarına sitenizin site haritasının bulunduğu URL’yi belirtmiş olursunuz.

User-agent: *

Disallow: /demo/

Allow: /demo/x-content

Sitemap:https://tulidijital.com/sitemap_index.xml

Bu komut, tüm botların site haritasının yolunu belirtmiş olursunuz.

Yıldız (*) ve Dolar ($) İşaretleri

Robots.txt dosyasındaki bazı özel karakterler, daha esnek ve kapsamlı kurallar belirlemenize olanak tanır. Bunlar wildcard (*) ve dolar işareti ($) gibi karakterlerdir.

Yıldız (*)

Yıldız (*) işareti, her şeyi temsil eder ve bir dizi sayfayı kapsamak için kullanılabilir. Bu, özellikle URL’nin belirli kısımlarını hedef alırken çok faydalıdır.

User-agent: *

Disallow: /products/*

Bu komut, /products/ dizinindeki tüm alt sayfalara (örneğin /products/item1 gibi) erişimi engelleyecektir.

Dolar ($)

Dolar işareti ($), URL’nin sonunda belirtilen karakterleri ifade eder. Bu, özellikle belirli bir URL sonlandırma şekline göre tarama yapmayı kontrol etmek için kullanışlıdır.

User-agent: *

Disallow: /*.pdf$

Bu komut, .pdf uzantısıyla biten tüm sayfalara erişimi engeller.

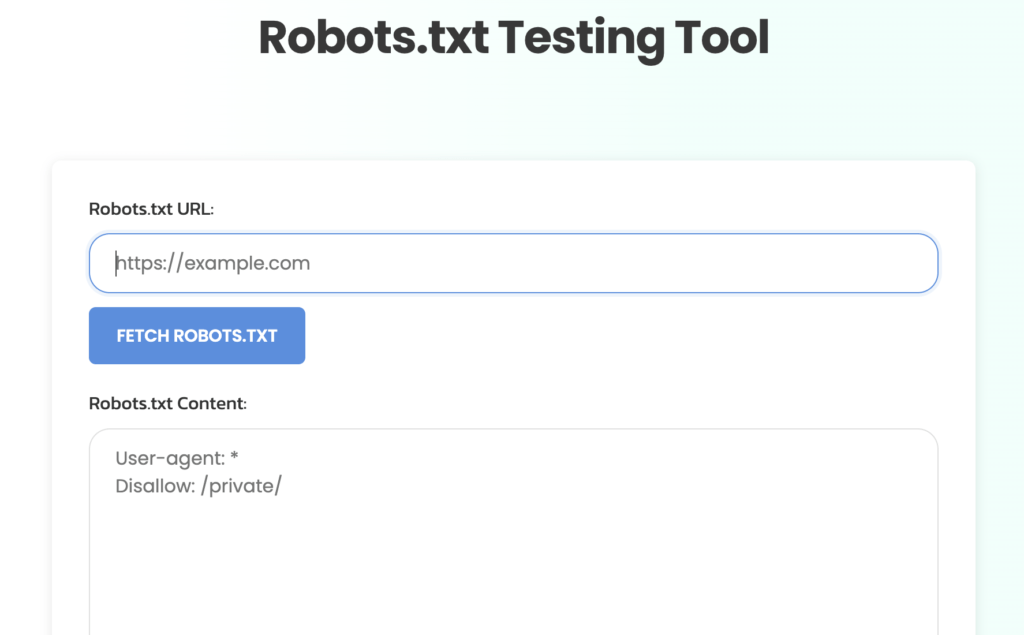

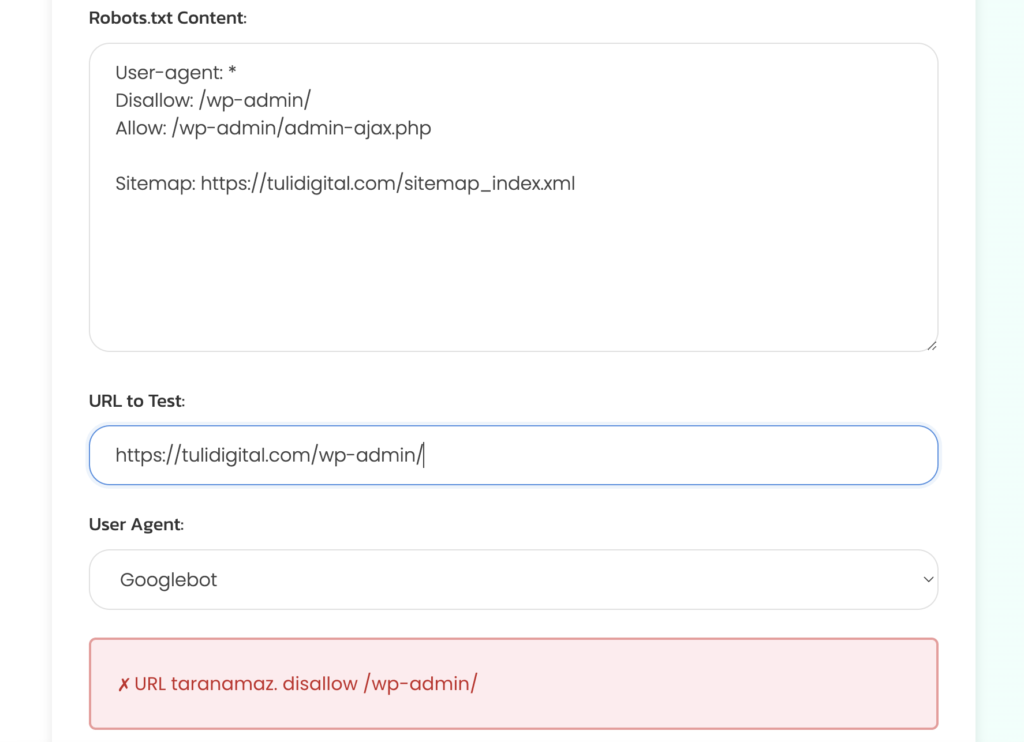

Robots.tx Test Aracı

Robots.txt dosyasını oluşturduktan sonra, komutların düzgün bir şekilde çalışıp çalışmadığını kontrol etmek önemlidir. Bu kontrol için çeşitli robots.txt test araçları kullanılabilir. Bu araçlar, komutlarınızı analiz ederek daha iyi bir SEO stratejisi oluşturmanıza yardımcı olabilir.

Komutları yayına almadan önce tek tek kontrol ederek, her bir komutun ne gibi sonuç verdiğini inceleyebilirsiniz. Ayrıca, bot simülasyonlarını kullanarak, komutun doğru çalışıp çalışmadığını kontrol edebilirsiniz.

Tüm kontroller tamamlandığında, komutların son halini yayımlayarak kullanıma alabilirsiniz.

1-Robots.txt url adresini girin ve ardından Fetch Robots.txt butonuna tıklayın.

2-Url to Test kısmında test etmek istediğiniz url adresini yazın.

Resimdeki aracın linki : https://tulidijital.com/robots-txt-testing-tool

Google Search Console Kontrolleri

Yayına aldığınız Robots.txt komutlarına dair yapabileceğiniz son kontroller için Google Search Console’u kullanabilirsiniz. Bunun için:

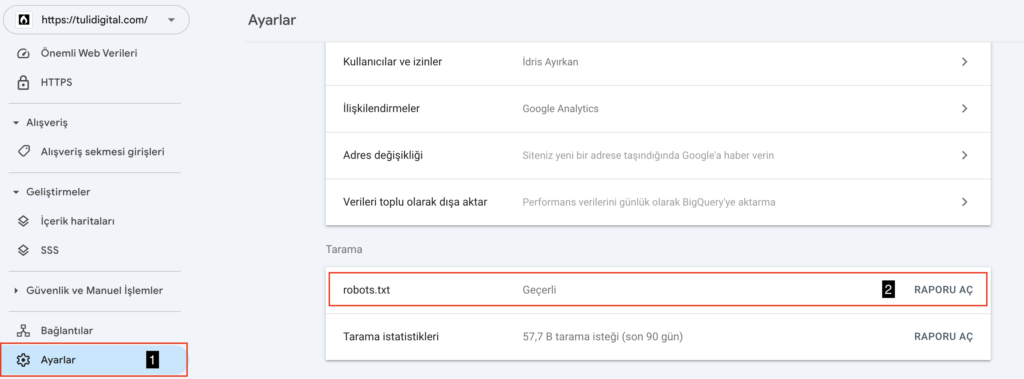

- Hesabınıza giriş yapıp, sol taraftaki menüdeki ‘Ayarlar(1)’ kısmına tıklayın.

- Sonrasında “Tarama” kısmının altındaki robots.txt alanında “RAPORU AÇ” kısmına tıklayın.

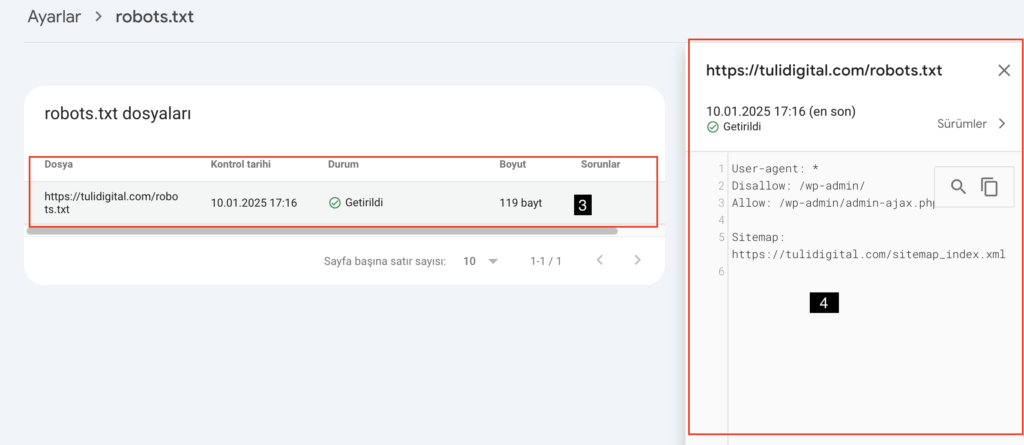

- Robots.txt dosyaları altında çıkan herhangi bir alana tıklayın.(3)

- Sağ tarafta robots.txt dosyanızın görüntüsü(4)

Yapılan incelemeye göre, robots.txt dosyasına ait bilgiler başarıyla kontrol edilmiştir. Son tarama işlemi 10.01.2025 17:16 tarihinde gerçekleştirilmiş ve herhangi bir sorun bulunmadığı tespit edilmiştir.